Des Pixels à la Personnalisation : Comment HunyuanCustom de Tencent Redéfinit la Génération Vidéo par IA

La Révolution Silencieuse de la Création Vidéo par IA

Le 8 mai 2025, Tencent a lancé une mise à jour majeure dans le monde de l'IA générative – et la plupart des gens ne l'ont pas remarquée. Mais si vous travaillez dans le marketing, les médias, l'e-commerce ou l'investissement en IA, HunyuanCustom est un nom que vous voudrez retenir. Cette sortie n'est pas juste un modèle de plus dans le paysage saturé des outils de génération vidéo – c'est un changement au niveau de l'infrastructure. Le modèle offre quelque chose qu'aucune plateforme ouverte ou fermée n'a livré de manière convaincante à grande échelle : une personnalisation vidéo multimodale avec une identité cohérente.

Dans un monde de plus en plus dominé par les médias synthétiques, maintenir l'authenticité d'une identité numérique à travers les images, les actions et les entrées n'est pas seulement un défi technique – c'est une nécessité commerciale. Que vous déployiez un ambassadeur de marque numérique, animiez l'apparence d'une célébrité, ou remplaciez des personnages dans un contenu vidéo sans refaire le tournage, la cohérence d'identité est la variable décisive.

HunyuanCustom s'attaque directement à ce problème avec une série d'innovations architecturales. Le résultat ? Un grand pas en avant en matière de contrôlabilité, de personnalisation et de cohérence visuelle – trois piliers du contenu synthétique évolutif.

Pourquoi Est-ce Important Maintenant ?

La vidéo représente déjà plus de 80 % du trafic internet. L'IA générative est utilisée pour accélérer tout, de la production publicitaire et la création d'avatars aux instructeurs virtuels et aux présentations de produits animées. Mais jusqu'à présent, un problème a limité une adoption plus large : l'incohérence. Les visages se transforment d'une image à l'autre. L'audio ne correspond pas aux mouvements des lèvres. L'identité devient floue en mouvement.

HunyuanCustom de Tencent s'attaque de front à ces défauts, en intégrant des entrées de contrôle multimodales (texte, images, audio, vidéo) et en les assemblant en une sortie cohérente et contrôlée. C'est plus qu'une simple mise à niveau de fonctionnalités – c'est une amélioration de l'infrastructure sur laquelle on peut construire.

Pour les investisseurs, le message est clair : HunyuanCustom est positionné pour être un modèle de base pour le contenu vidéo IA de qualité professionnelle. Et son engagement en open source pourrait faire pencher la balance dans la dynamique future des parts de marché.

Au Cœur de l'Architecture : Qu'est-ce Qui Rend HunyuanCustom Différent ?

Décortiquons les innovations clés et pourquoi elles sont importantes pour les développeurs et les utilisateurs d'entreprise :

1. Le Conditionnement Multimodal Qui Fonctionne

Contrairement à de nombreux prédécesseurs qui échouent sous des combinaisons d'entrées complexes, HunyuanCustom fusionne le texte, les images, l'audio et la vidéo en une sortie cohérente. Que vous souhaitiez un jumeau numérique parlant d'un PDG ou un mannequin virtuel réagissant au son ambiant, ce modèle peut le gérer.

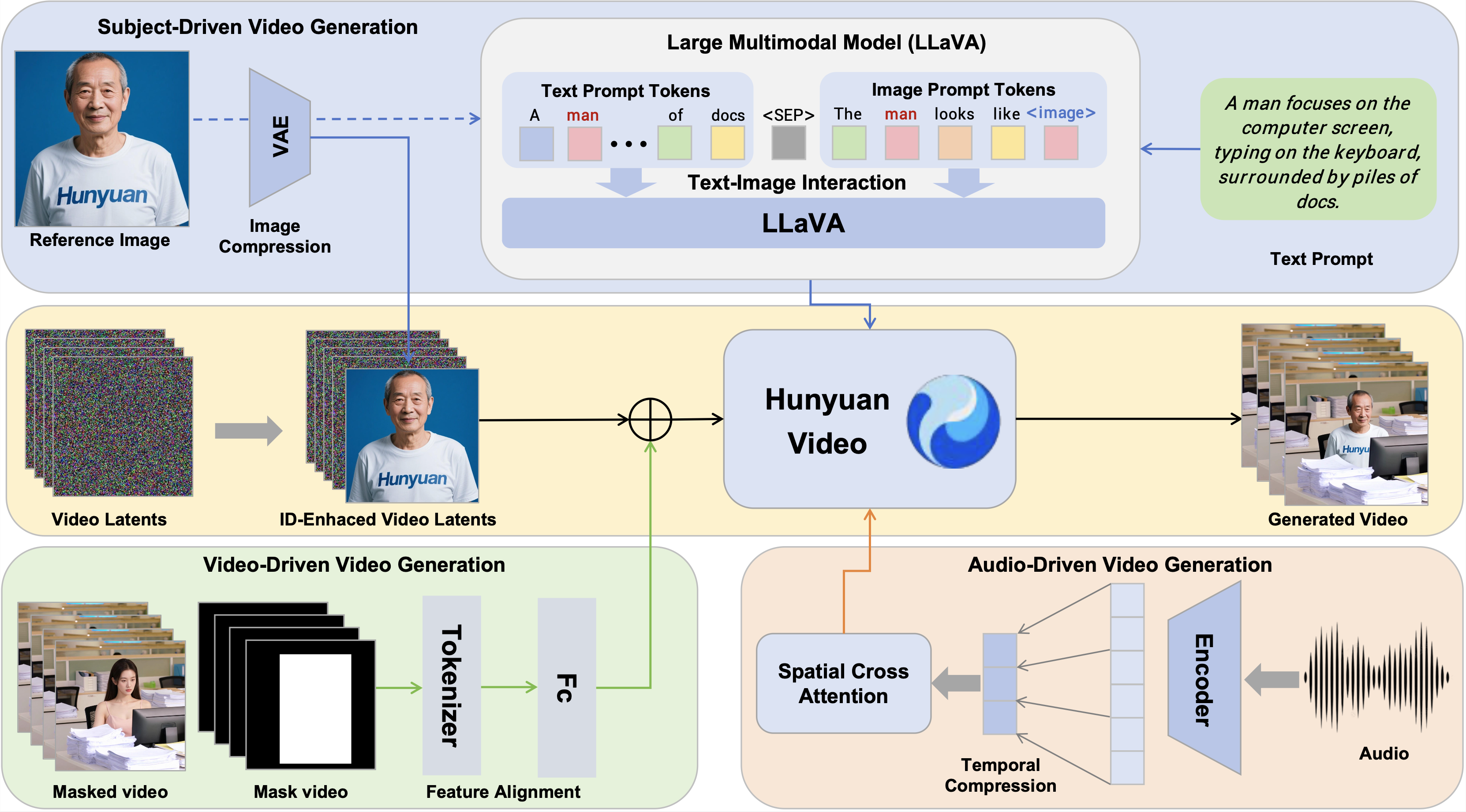

📌 Innovation clé : La Fusion Texte-Image basée sur LLaVA crée une compréhension unifiée de l'identité visuelle et des instructions verbales – essentielle pour des mouvements et expressions naturels.

2. Moteur de Cohérence d'Identité

Au cœur du système se trouve le Module d'Amélioration de l'Identité d'Image. Utilisant les VAE latents et les intégrations positionnelles 3D, il propage l'identité d'un sujet à travers les images vidéo sans simplement "copier-coller" les traits du visage. Cela garantit que le sujet reste reconnaissable en mouvement, en cas d'occlusion ou de changements d'expression.

📌 Pourquoi c'est important : Les modèles précédents souffraient de tremblements et de perte d'identité au fil du temps. Les améliorations de la cohérence temporelle de HunyuanCustom corrigent cela.

3. L'Audio Sans Dérive

Dans les modèles traditionnels, injecter de l'audio pour synchroniser les lèvres dégrade souvent l'identité visuelle du sujet. La solution de Tencent : l'AudioNet à Identité Désintriquée, qui applique une attention croisée spatiale par image, assurant une synchronisation précise sans distorsion visuelle.

📌 Pertinence commerciale : Permet la création d'avatars virtuels au son naturel pour le support client, l'e-learning ou le marketing interactif.

4. Montage Vidéo Rapide et Efficace Basé sur la Vidéo

HunyuanCustom permet également d'utiliser des vidéos existantes comme sources d'entrée – par exemple, remplacer un personnage en arrière-plan ou insérer un nouveau porte-parole dans une publicité précédemment filmée.

📌 Avancée technique : Son Module d'Injection Basé sur la Vidéo ajoute des fonctionnalités encodées à partir de vidéos de référence directement dans le flux de génération avec une charge computationnelle minimale.

Évaluer la Promesse : Est-ce Vraiment Mieux ?

Dans les comparaisons techniques avec des plateformes open source et commerciales comme Vidu, Pika, Keling et Skyreels, HunyuanCustom est en tête sur plusieurs fronts.

| Modèle | Face-Sim (↑) | DINO-Sim (↑) | Cohérence Temporelle (↑) |

|---|---|---|---|

| Vidu 2.0 | 0.424 | 0.537 | 0.961 |

| Keling 1.6 | 0.505 | 0.580 | 0.914 |

| Pika | 0.363 | 0.485 | 0.928 |

| HunyuanCustom | 0.627 | 0.593 | 0.958 |

Ces chiffres indiquent un modèle qui surpasse en préservation de l'identité, réalisme de la scène, et cohérence temporelle. Ce n'est pas seulement une victoire technique – c'est un facilitateur commercial.

Applications Concrètes à Potentiel Commercial

La force de HunyuanCustom réside dans son adaptabilité à différents cas d'usage :

Publicité et Marketing

Les marques peuvent déployer des ambassadeurs numériques cohérents dans des campagnes localisées, avec des messages synchronisés avec les lèvres en plusieurs langues.

Essayage Virtuel et E-commerce

Les marques de vêtements peuvent générer des démonstrations de mouvement réalistes à partir d'images fixes, réduisant ainsi la dépendance aux tournages coûteux.

Éducation et Formation

Des instructeurs vidéo personnalisés peuvent être créés pour différents segments démographiques, conservant une qualité visuelle et sonore cohérente.

Montage et Production Vidéo

Les studios peuvent désormais adapter d'anciennes séquences vidéo avec de nouveaux personnages ou messages sans refaire les tournages ni créer d'artefacts de deepfake.

Jeux et Métavers

Des avatars réalistes peuvent être animés à partir d'une entrée minimale, débloquant la personnalisation de nouvelle génération pour les mondes virtuels.

Défis et Points à Considérer pour l'Adoption

Bien que la performance soit prometteuse, quelques points d'attention méritent d'être notés :

- Exigences Matérielles : Le modèle recommande 80 Go de mémoire GPU pour un résultat optimal – ce qui signifie qu'il n'est pas "prêt à l'emploi" pour la plupart des créateurs.

- L'Avantage de Tencent : L'échelle et la qualité du système découlent de la base de ressources de Tencent. Reproduire des résultats similaires pourrait ne pas être facile sans une infrastructure similaire.

- Validation par des Tiers : Bien que le modèle soit open source, bon nombre de ses comparaisons de performance sont réalisées en interne. Une adoption généralisée dépendra de la réplication et de la validation par la communauté.

Une Infrastructure pour la Prochaine Économie du Contenu

HunyuanCustom n'est pas juste un autre modèle d'IA – c'est une avancée au niveau de la plateforme pour la manière dont les entreprises peuvent générer, personnaliser et faire évoluer du contenu vidéo de haute qualité. La décision de le mettre à disposition en open source le rend encore plus disruptif, surtout sur un marché concurrentiel saturé de solutions fermées.

Pour les créateurs de contenu, les agences et les investisseurs, HunyuanCustom représente un tournant. Avec un contrôle supérieur de l'identité, une flexibilité multimodale et une performance de niveau entreprise, il offre la colonne vertébrale de la prochaine phase des médias synthétiques.