NVIDIA étend son influence alors que Meta et Oracle adoptent l'Ethernet Spectrum-X pour alimenter les systèmes d'IA de nouvelle génération

Le nouveau champ de bataille de la Silicon Valley : au cœur de l'audacieuse stratégie de NVIDIA pour recâbler le système nerveux de l'IA

Meta et Oracle adoptent l'Ethernet Spectrum-X, une décision qui pourrait redessiner l'architecture de l'intelligence artificielle – et tester les limites de l'influence d'une seule entreprise.

SAN JOSE, Californie — Les centres de données qui alimentent le boom actuel de l'intelligence artificielle atteignent leurs limites. Leurs réseaux neuronaux ne cessent de croître, mais les « tuyaux » numériques qui les connectent ne peuvent tout simplement plus suivre.

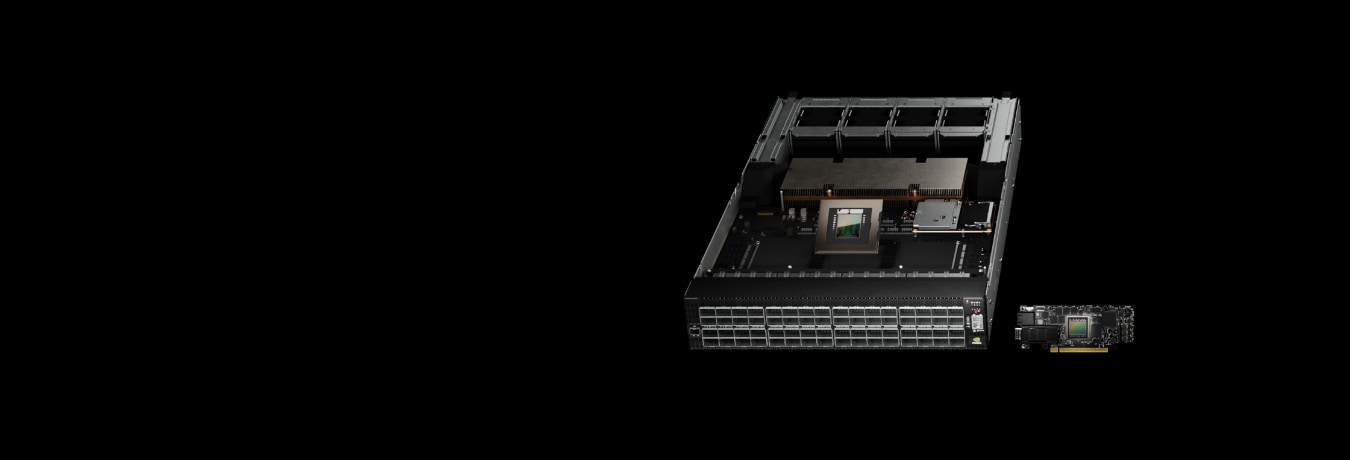

Lundi, NVIDIA a révélé que Meta et Oracle prévoyaient de déployer ses commutateurs Ethernet Spectrum-X à travers leurs vastes infrastructures d'IA. Cette décision étend la domination de NVIDIA au-delà des puces, directement dans le tissu conjonctif qui permet aux systèmes d'apprentissage automatique de « penser » et de communiquer entre eux.

C'est une étape majeure pour les deux entreprises, bien que pour des raisons différentes. Meta, célèbre pour son approche open source et multi-fournisseurs, et Oracle, connue pour son intégration étroite et tout-en-un, empruntent rarement le même chemin. Leur vote de confiance commun envers NVIDIA marque un tournant possible dans la manière dont les géants de la technologie construisent ce que Jensen Huang, PDG de NVIDIA, aime appeler des « usines d'IA ».

Mais sous l'enthousiasme se cache une question qui traverse l'ensemble de l'industrie : l'avenir de l'IA reposera-t-il sur des systèmes étroitement contrôlés et intégrés verticalement, détenus par des fournisseurs uniques – ou sur des standards ouverts et flexibles qui maintiennent la compétitivité du marché et le contrôle des acheteurs ?

Quand les réseaux deviennent des goulots d'étranglement

Le problème se résume à la physique. Alors que les modèles de langage actuels atteignent des milliers de milliards de paramètres, ils s'appuient sur des milliers de GPU échangeant constamment des données — mises à jour de gradients, poids de modèles, et tout ce qui se trouve entre les deux. Ces allers-retours incessants inondent le réseau d'énormes rafales de trafic.

L'équipement Ethernet traditionnel n'a tout simplement pas été conçu pour un tel traitement. Les analystes estiment que les réseaux de centres de données typiques n'atteignent qu'environ 60 % de débit effectif lors de l'entraînement de l'IA. Le reste est absorbé par la congestion, les délais de mise en tampon et les collisions de trafic. Chaque point de pourcentage perdu signifie des GPU inactifs — des millions de dollars de matériel qui attendent, à tourner en rond.

NVIDIA affirme que son système Spectrum-X change la donne. En associant des commutateurs conçus spécifiquement à des cartes réseau personnalisées et à un logiciel optimisé pour l'IA, l'entreprise déclare pouvoir porter le taux d'utilisation à 95 %. La plateforme prédit où la congestion se formera et redirige les données avant que cela ne devienne un problème. Ces chiffres, selon NVIDIA, proviennent directement de ses propres supercalculateurs — bien que la validation externe dans des configurations multi-fournisseurs réelles reste limitée.

L'équation des hyperscalers

Parmi les deux adopteurs, la décision de Meta attire plus l'attention. L'entreprise a pratiquement écrit le livre blanc sur le réseau ouvert, évitant le verrouillage propriétaire en mélangeant et associant des équipements de Broadcom, Arista et d'autres. Le fait de voir Meta intégrer la technologie NVIDIA dans ses commutateurs Minipack3N et son logiciel Facebook Open Switching System suggère donc quelque chose de significatif : soit le matériel de NVIDIA est vraiment très en avance, soit Meta a décidé que les performances de l'IA et la conception du réseau ne peuvent plus être traitées séparément.

Des sources internes chuchotent que Meta ne jette pas le bébé avec l'eau du bain. Au lieu de cela, l'entreprise fera probablement fonctionner Spectrum-X aux côtés de son infrastructure Broadcom existante — couvrant ses arrières tout en gardant ses options ouvertes.

Le mouvement d'Oracle, en revanche, correspond à son schéma habituel. L'entreprise a construit sa stratégie cloud autour d'une collaboration approfondie avec NVIDIA. Son adoption de Spectrum-X s'aligne sur l'architecture de nouvelle génération « Vera Rubin » — conçue pour relier des millions de GPU en ce que les partenaires appellent des « usines d'IA à l'échelle giga ». Pour Oracle, la logique est simple : lorsque la vitesse et la fiabilité sont primordiales, l'intégration l'emporte toujours sur la modularité.

La riposte du silicium commercial

L'élan de NVIDIA n'est pas passé inaperçu. Broadcom, dont les puces constituent l'épine dorsale d'une grande partie d'Internet, a récemment décroché un accord majeur de mise en réseau d'IA avec OpenAI, basé sur ses propres conceptions optimisées pour l'Ethernet. Cisco promeut ses puces Silicon One P200 pour les connexions longue distance qui relient les centres de données à travers les continents, avec Microsoft et Alibaba déjà clients.

Pendant ce temps, l'Ultra Ethernet Consortium — une alliance de poids lourd incluant AMD, Arista, Broadcom, Cisco, Intel, Meta et Microsoft — a lancé sa spécification 1.0. Son objectif ? Égaler les performances de NVIDIA sans enfermer les clients dans un seul fournisseur. En d'autres termes, c'est une attaque coordonnée contre les piles logicielles propriétaires.

Les enjeux ne pourraient être plus élevés. Les analystes s'attendent à ce que la mise en réseau des centres de données d'IA génère entre 80 et 100 milliards de dollars de revenus de commutateurs au cours des cinq prochaines années. Alors que les vitesses Ethernet passent de 800 Gbit/s à 1,6 Tbit/s, le défi de NVIDIA est clair : conserver son avance tandis que le reste de l'industrie s'empresse de la rattraper.

Décrypter les revendications de performance

Cette affirmation de débit de 95 contre 60 % semble impressionnante, mais le contexte est important. Les chiffres de NVIDIA proviennent de ses propres laboratoires de test, dans des conditions idéales et avec des charges de travail optimisées pour son équipement. Sur le terrain — où les réseaux sont désordonnés, mixtes et imprévisibles — les résultats peuvent être très différents.

Les concurrents n'adhèrent pas non plus à toute l'histoire. Des ingénieurs familiers des déploiements Jericho4 de Broadcom affirment que leurs systèmes peuvent atteindre des taux d'efficacité dans les 80 % supérieurs lorsqu'ils sont correctement réglés. L'écart restant, selon eux, est moins lié au matériel qu'à la manière dont les réseaux sont architecturés et optimisés.

Malgré tout, on ne peut nier l'avantage de NVIDIA en matière d'intégration. Ses cartes réseau, commutateurs, bibliothèques logicielles et contrôles de congestion fonctionnent tous comme un seul organisme cohésif. C'est difficile à reproduire dans un écosystème ouvert, où plusieurs fournisseurs doivent cohabiter harmonieusement. Que les clients accepteront moins de flexibilité pour cet avantage de performance dépend de la valeur qu'ils accordent à la liberté par rapport à la vitesse.

Le pari de l'expansion à l'échelle

La prochaine frontière n'est pas seulement des modèles plus grands, mais leur répartition. La nouvelle technologie Spectrum-XGS de NVIDIA vise à connecter des centres de données entiers en clusters d'entraînement unifiés et mondiaux. Alors que les modèles deviennent trop grands pour un seul site, et que les fermes de GPU énergivores recherchent de l'énergie abordable à travers les régions, la capacité de coordonner l'entraînement à travers les continents devient cruciale.

Ici, NVIDIA fait face à Cisco de plein fouet. Le silicium à mémoire tampon profonde de Cisco est conçu sur mesure pour le trafic d'IA longue distance. La bataille ne sera pas décidée par les spécifications brutes, mais par la capacité de chaque plateforme à gérer la latence et les pannes qui accompagnent les tâches d'entraînement distribuées. Lorsque vous synchronisez des GPU sur des milliers de kilomètres, même un accroc peut faire dérailler une exécution entière.

Perspectives d'investissement et signaux pour l'avenir

Pour les investisseurs et les analystes, l'angle commercial est clair. Le réseau pourrait devenir le prochain grand moteur de profit de NVIDIA. Au-delà des commutateurs eux-mêmes, il y a de l'argent à gagner dans les cartes réseau, l'optique et le logiciel qui lie le tout. Si NVIDIA s'empare de 10 à 20 % du marché de l'Ethernet pour l'IA, les analystes estiment que cela pourrait générer un chiffre d'affaires annuel de plusieurs dizaines de milliards de dollars (bas de la fourchette) d'ici 2027 — avec des marges juteuses d'environ 35 % pour accompagner cela.

Mais la concurrence s'intensifie rapidement. Le partenariat de Broadcom avec OpenAI prouve que le silicium commercial reste pertinent. La poussée de l'Ultra Ethernet Consortium en faveur des standards ouverts pourrait réduire le pouvoir de fixation des prix de NVIDIA d'ici deux à trois ans si une parité de performance est atteinte. Historiquement, les hyperscalers comme Meta préfèrent acheter auprès de plusieurs sources, ce qui suggère qu'ils ne donneront pas les clés à NVIDIA sans plan de secours.

Pour les fabricants d'équipements, les effets d'entraînement varient. Arista Networks fait face à la menace la plus aiguë, car le matériel de NVIDIA empiète désormais sur son territoire. Cisco pourrait trouver sa niche dans la connectivité longue distance, mais il devra agir rapidement. Broadcom reste résilient grâce à sa clientèle diversifiée, même s'il perd des parts sur certains comptes IA spécifiques.

Points clés à surveiller : les performances des déploiements réels de Meta et Oracle ; l'évolution de la demande pour les optiques à 1,6 térabit ; et si les régulateurs commencent à s'interroger sur le contrôle croissant de NVIDIA sur l'écosystème.

Et comme toujours, les investisseurs doivent se souvenir que les performances passées ne sont pas garantes de l'avenir. Le paysage du réseau de semi-conducteurs évolue rapidement, façonné par les avancées technologiques, les surprises concurrentielles et les normes changeantes. Rester informé et diversifié n'est pas seulement judicieux, c'est essentiel.

La question ouverte

En fin de compte, le dilemme central demeure. L'infrastructure d'IA va-t-elle se consolider autour de plateformes étroitement intégrées, à la recherche de la moindre goutte de performance ? Ou restera-t-elle ouverte, distribuée et compétitive ?

L'annonce de lundi fait pencher le pendule vers l'intégration, mais elle met également le feu aux poudres dans le camp des standards ouverts. Les deux parties savent que la course ne concerne pas seulement la vitesse brute, mais aussi qui contrôlera l'architecture de l'ère de l'IA elle-même.

Ce que Meta et Oracle construiront à partir de maintenant — et s'ils garderont la porte ouverte aux alternatives — nous dira quelle vision l'emportera dans cette nouvelle ère d'intelligence à l'échelle giga.

CECI N'EST PAS UN CONSEIL EN INVESTISSEMENT