Le pari à 100 milliards de dollars : NVIDIA et OpenAI forgent un partenariat qui pourrait redéfinir l'avenir de l'IA

Une alliance stratégique pour une infrastructure de 10 gigawatts marque une ampleur sans précédent dans le calcul pour l'intelligence artificielle, signalant un virage de l'industrie vers des usines d'IA gourmandes en énergie.

NVIDIA Corporation et OpenAI ont annoncé dimanche un partenariat stratégique historique qui verra le fabricant de puces investir jusqu'à 100 milliards de dollars pour déployer au moins 10 gigawatts de systèmes d'IA destinés à l'infrastructure de nouvelle génération d'OpenAI.

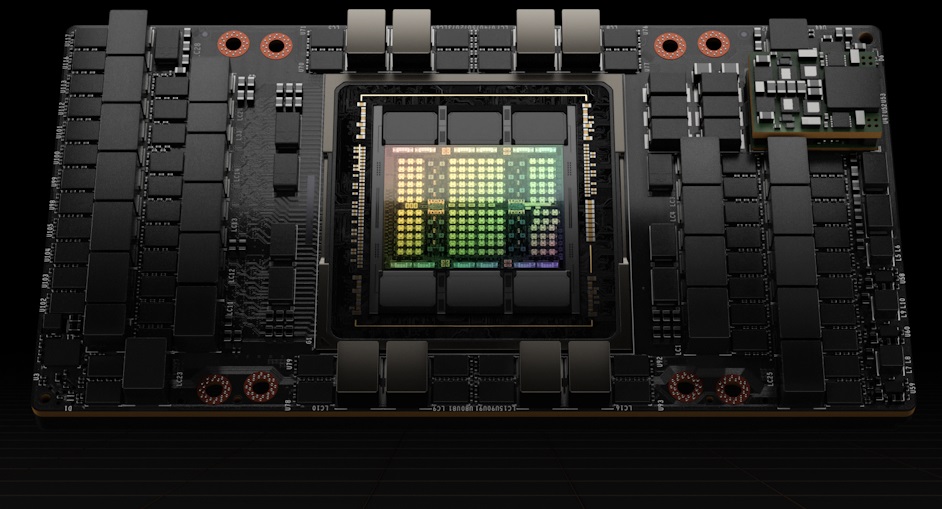

L'accord, formalisé par une lettre d'intention, représente l'un des engagements de capitaux les plus importants dans l'histoire brève mais explosive du secteur de l'IA. Le partenariat déploiera progressivement des millions de GPU NVIDIA alors qu'OpenAI construira ce que les experts de l'industrie décrivent comme des "usines d'IA" conçues pour entraîner et exploiter des systèmes superintelligents.

Le premier gigawatt de capacité devrait être mis en service au second semestre 2026, utilisant la future plateforme Vera Rubin de NVIDIA. Ce déploiement initial consommerait à lui seul environ la même quantité d'énergie en continu qu'une grande zone métropolitaine, soulignant l'ampleur de l'infrastructure requise pour le développement de l'IA de pointe.

Quand la Silicon Valley rencontre le réseau électrique

L'engagement de 10 gigawatts représente environ 87,6 térawattheures (TWh) de consommation annuelle d'énergie, soit l'équivalent de la consommation électrique de pays comme la Belgique ou le Chili. Les analystes de l'industrie estiment que cette infrastructure pourrait accueillir entre 5,6 et 10,4 millions d'accélérateurs GPU sur plusieurs campus de centres de données, représentant une valeur matérielle potentiellement supérieure à 400 milliards de dollars.

La consommation annuelle d'énergie projetée de 87,6 TWh de l'infrastructure d'IA de 10 gigawatts comparée à la consommation annuelle d'électricité de pays sélectionnés.

| Pays/Infrastructure | Consommation annuelle d'électricité (TWh) |

|---|---|

| Infrastructure IA | 87,6 |

| Chili | 83,3 |

| Belgique | 78 |

| Norvège | 135,68 |

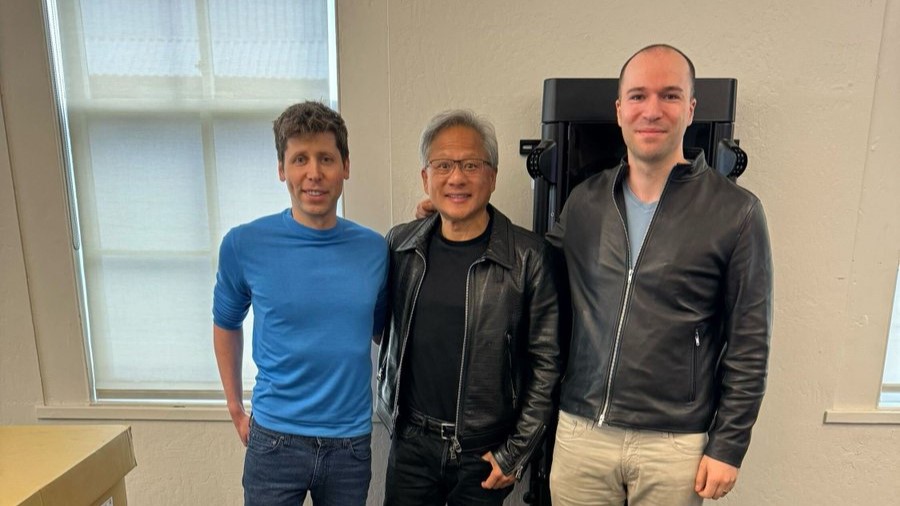

« Cet investissement et ce partenariat d'infrastructure marquent la prochaine étape décisive – déployer 10 gigawatts pour alimenter la prochaine ère de l'intelligence », a déclaré Jensen Huang, fondateur et PDG de NVIDIA, dans l'annonce. Son homologue, Sam Altman, PDG d'OpenAI, a souligné que « l'infrastructure de calcul sera la base de l'économie du futur ».

La structure du partenariat révèle une ingénierie financière sophistiquée. Selon des sources proches de l'arrangement, l'investissement en capital de NVIDIA sera échelonné en fonction du déploiement de l'infrastructure, avec environ 10 milliards de dollars engagés au franchissement du premier gigawatt. Cette approche transforme effectivement NVIDIA d'un fournisseur de matériel traditionnel en un partenaire en capital stratégique, partageant à la fois les risques et les bénéfices des plans d'expansion ambitieux d'OpenAI.

Rompre le cycle de dépendance au cloud

L'accord représente un virage stratégique pour OpenAI, qui a historiquement largement dépendu de l'infrastructure cloud Azure de Microsoft suite à l'investissement initial de 13 milliards de dollars du géant du logiciel. En obtenant un accès direct à du matériel de pointe grâce au partenariat avec NVIDIA, OpenAI gagne un levier de négociation crucial et une diversification de sa chaîne d'approvisionnement.

La dépendance vis-à-vis d'un fournisseur unique (vendor lock-in) dans l'informatique en nuage fait référence à la dépendance d'un client envers un seul fournisseur, ce qui rend difficile et coûteux de passer à un autre. Cela crée des risques tels qu'une flexibilité limitée et un potentiel d'augmentation des dépenses. Des stratégies multi-cloud sont souvent adoptées pour atténuer ces dépendances à un fournisseur unique.

Les observateurs du marché notent que cet arrangement complète plutôt qu'il ne remplace les relations existantes d'OpenAI. L'entreprise continue de collaborer avec Oracle via l'initiative Stargate et maintient son partenariat avec Microsoft, créant une approche multi-fournisseurs qui réduit les risques de dépendance à une source unique.

« OpenAI est en train de créer une concurrence entre les fournisseurs pour sa ressource la plus critique », a noté un analyste de l'industrie qui a requis l'anonymat en raison de ses relations avec des clients. « Cela pourrait modifier fondamentalement la dynamique des prix dans l'infrastructure d'IA. »

La grande course à l'armement de l'infrastructure d'IA

Le partenariat NVIDIA-OpenAI intervient au milieu d'une transformation plus large de l'industrie vers des déploiements massifs de calcul d'IA. Meta a évoqué publiquement des clusters multi-gigawatts pour ses ambitions en IA, tandis que xAI d'Elon Musk a rapidement construit le supercalculateur "Colossus". Microsoft a récemment annoncé des plans pour son centre de données Fairwater dans le Wisconsin, impliquant plus de 7 milliards de dollars d'investissement public.

La mise à l'échelle de cette infrastructure reflète un changement fondamental dans la philosophie du développement de l'IA. Contrairement aux paradigmes de calcul précédents axés sur l'efficacité algorithmique, les progrès actuels de l'IA dépendent de plus en plus de l'échelle de calcul brute. L'entraînement de modèles plus performants nécessite des clusters de GPU exponentiellement plus grands, créant une barrière gourmande en capital qui favorise les acteurs bien financés.

Dépenses d'investissement projetées dans l'infrastructure d'IA par les grandes entreprises technologiques, soulignant la "course à l'armement" qui s'intensifie.

| Entreprise | Dépenses d'investissement projetées dans l'infrastructure d'IA | Période/Notes |

|---|---|---|

| Microsoft | 80 milliards de dollars | Exercice fiscal 2025 |

| 120 milliards de dollars | Exercice fiscal 2026 | |

| 100 milliards de dollars | Prochain exercice fiscal (à compter d'août 2025) | |

| Meta | 60 - 65 milliards de dollars | Dépenses d'investissement 2025 |

| 66 - 72 milliards de dollars | Prochain exercice fiscal (à compter d'août 2025) | |

| 100 milliards de dollars | Évoqué pour l'investissement commercial de l'exercice fiscal 2026 | |

| xAI | 13 milliards de dollars | Plan de dépenses 2025, inclut le supercalculateur Colossus |

| Dizaines de milliards de dollars | Coût estimé pour le supercalculateur Colossus 2 | |

| Amazon | 100 milliards de dollars | Dépenses d'investissement projetées pour 2025 |

| 118 milliards de dollars | Montant prévu pour les dépenses de 2025 (à compter d'août 2025) | |

| Alphabet (Google) | 75 milliards de dollars | Dépenses d'investissement projetées pour 2025 |

| 85 milliards de dollars | Montant prévu pour le prochain exercice fiscal (à compter d'août 2025) |

Les contraintes énergétiques sont devenues le principal goulot d'étranglement, plutôt que la disponibilité des puces. Obtenir une énergie fiable et abordable – en particulier à partir de sources renouvelables – est devenu aussi critique que les chaînes d'approvisionnement en semi-conducteurs. Les entreprises doivent naviguer dans des processus d'autorisation complexes, les limitations des infrastructures de transmission et les réglementations environnementales dans plusieurs juridictions.

Implications d'investissement sur l'ensemble de la pile technologique

Les marchés financiers considéreront probablement ce partenariat comme la validation de plusieurs thèmes d'investissement. L'action NVIDIA a déjà bénéficié de la demande en infrastructure d'IA, mais cet accord offre une visibilité sans précédent sur les revenus s'étendant jusqu'en 2029. La structure d'investissement échelonnée positionne également NVIDIA pour capter les bénéfices potentiels du succès d'OpenAI tout en atténuant les risques de baisse.

Le partenariat crée des effets d'entraînement tout au long de la chaîne d'approvisionnement technologique. Les fournisseurs de mémoire à large bande passante (HBM), notamment SK Hynix, Micron et Samsung, devraient bénéficier d'une demande soutenue, bien que des pressions sur les prix pourraient apparaître d'ici 2026 à mesure que la capacité de production s'étendra. Les spécialistes de l'encapsulation avancée et les services de fonderie, en particulier Taiwan Semiconductor Manufacturing Company, font face à des contraintes de capacité continues pour soutenir la production accélérée de puces.

Les entreprises d'infrastructures électriques et d'énergies renouvelables pourraient connaître une attention accrue des investisseurs, car les entreprises d'IA recherchent des arrangements énergétiques dédiés. Certains analystes suggèrent que cela pourrait accélérer l'adoption de petits réacteurs modulaires nucléaires et de solutions de stockage d'énergie à l'échelle du réseau spécifiquement conçues pour les charges de calcul à haute densité.

Naviguer entre les vents contraires réglementaires et techniques

Le partenariat fait face à plusieurs facteurs de risque importants qui pourraient affecter les délais d'exécution et les rendements financiers. L'examen réglementaire semble de plus en plus probable, car les autorités antitrust examinent les implications concurrentielles des fournisseurs de matériel prenant des participations dans de grands clients tout en dominant des parts de marché.

Les préoccupations environnementales concernant la consommation d'énergie pour l'entraînement de l'IA pourraient déclencher des interventions politiques limitant les attributions d'énergie ou imposant des mécanismes de tarification du carbone. La consommation d'eau pour les systèmes de refroidissement et l'utilisation des terres pour la construction de centres de données pourraient faire face à l'opposition locale dans les marchés géographiques préférés.

Les risques techniques incluent des percées potentielles dans les architectures de calcul alternatives qui pourraient réduire les avantages concurrentiels de NVIDIA. Les développements de puces personnalisées par les fournisseurs de cloud ou les avancées en informatique quantique pourraient perturber les dépendances matérielles actuelles, bien que de telles transitions nécessitent généralement plusieurs années pour se matérialiser.

Les Petits Réacteurs Modulaires (PRM) sont des réacteurs nucléaires avancés et compacts conçus pour une production d'énergie efficace et modulaire. Ces unités sont de plus en plus explorées comme une source d'énergie fiable et sans carbone pour les applications à forte demande, y compris l'alimentation des vastes centres de données essentiels à l'infrastructure d'intelligence artificielle.

La question à mille milliards de dollars : quelle est la prochaine étape ?

Ce partenariat signale que le développement de l'IA est entré dans une nouvelle phase où le succès dépend autant des capacités d'infrastructure que de l'innovation algorithmique. Les entreprises désireuses et capables d'engager des centaines de milliards dans l'infrastructure de calcul pourraient déterminer quels systèmes d'IA atteindront finalement un déploiement généralisé.

Les observateurs du marché devraient surveiller plusieurs indicateurs clés dans les mois à venir : les termes de l'accord définitif, les accords d'achat d'électricité pour des emplacements spécifiques de centres de données, et des preuves de partenariats similaires entre les entreprises d'IA concurrentes. Le rythme de développement de la plateforme Vera Rubin et les premiers déploiements commerciaux fourniront des signaux précoces sur les capacités d'exécution.

Pour les investisseurs, le partenariat NVIDIA-OpenAI représente à la fois une opportunité et un risque de concentration. Bien qu'il étende le leadership de NVIDIA en matière d'infrastructure d'IA tout au long de la décennie, il augmente également la dépendance vis-à-vis d'une relation client unique qui pourrait faire face à des défis réglementaires ou à des perturbations techniques.

L'implication plus large s'étend au-delà des marchés financiers aux questions de concentration du développement de l'IA entre un petit nombre d'entités bien capitalisées. À mesure que les exigences en matière d'infrastructure augmentent de manière exponentielle, le nombre d'organisations capables de former des systèmes d'IA de pointe pourrait diminuer, affectant potentiellement la diversité de l'innovation et la dynamique concurrentielle dans l'intelligence artificielle.

Thèse d'investissement de la rédaction

| Catégorie | Détails récapitulatifs |

|---|---|

| Analyse Exécutive | Une verticalisation par paliers où NVIDIA devient un partenaire en capital pour verrouiller les charges de travail IA clés. OpenAI gagne une marge de calcul pluriannuelle et un effet de levier sur les fournisseurs. L'échelle est d'abord énergétique (10 GW ≈ 87,6 TWh/an, alimentant ~6-10M accélérateurs), faisant de l'approvisionnement en énergie l'élément limitant. Environ 70 % de chances pour un accord définitif, un glissement de calendrier étant plus probable qu'une annulation. |

| Quoi de neuf | 100 milliards de dollars de NVIDIA, basés sur l'avancement (par exemple, 10 milliards de dollars pour 1 GW à une valorisation d'OpenAI d'environ 500 milliards de dollars). Coût total de l'infrastructure jusqu'à 400 milliards de dollars. Objectif de 10 GW, première vague sur la plateforme "Vera Rubin" à partir du second semestre 2026. L'accord n'est pas exclusif, complétant les autres plans d'OpenAI (par exemple, Stargate avec Oracle) et rééquilibrant sa dépendance vis-à-vis de Microsoft. |

| Tendance vs. Exception | Tendance : Les usines d'IA multi-gigawatts sont la nouvelle unité concurrentielle (exemples : OpenAI-Oracle Stargate, Microsoft Fairwater, Meta, xAI). Exception : L'ampleur d'un fournisseur (NVIDIA) investissant en capital dans un client (OpenAI) pour verticaliser les économies et augmenter le coût du capital des rivaux. |

| Chiffres Clés (Estimations) | Énergie : 10 GW = 87,6 TWh/an. Dépenses d'exploitation (Opex) : 2,6 à 8,8 milliards de dollars/an pour l'énergie seule. Accélérateurs : ~5,6M-10,4M GPU. TAM (Marché Adressable Total) Matériel Implicite : 300 à 600 milliards de dollars de potentiel de revenus cumulés pour l'industrie. |

| Économie & P&L - NVIDIA | Revenus : 300 à 500 milliards de dollars de ventes cumulées de 6 à 9 millions d'accélérateurs sur 3 à 5 ans. Marge : Hautement relutive, avec une marge brute (MB) récente d'environ 72-76 % ; le passage aux systèmes pourrait tempérer la MB maximale. Risques : Concentration client, antitrust, chaîne d'approvisionnement et retards d'implantation électrique. |

| Économie & P&L - OpenAI | Gagnant Stratégique : Sources de calcul diversifiées, co-optimisation de la feuille de route et concurrence des fournisseurs. Structure du Capital : Réalignement association/Microsoft plus le capital de NVIDIA ajoute un pilier non contrôlant. Le risque d'exécution reste élevé. |

| Bénéficiaires de Second Ordre | Fournisseurs HBM (SK hynix, Micron, Samsung) ; Encapsulation avancée (TSMC, ASE, Amkor) ; Services publics d'électricité et de réseau ; OEMs de systèmes et réseaux (par exemple, Supermicro). |

| Causes Fondamentales | 1. Le calcul est le facteur limitant pour la qualité des modèles. 2. L'énergie est le goulot d'étranglement. 3. Nécessité de co-conception HW-SW. 4. Géopolitique/incitations à la relocalisation. |

| Risques | Réglementaire : Examen antitrust. Exécution : Retards d'implantation/d'autorisation énergétique. Technologique : Succès des puces personnalisées ou l'efficacité algorithmique réduit la demande en FLOPs. Financier : Pression politique due à l'optique de la "circularité". |

| Scénarios (Probabilités) | Scénario de Base (55 %) : Accord définitif dans 3 à 6 mois ; déploiements échelonnés avec des glissements partiels. Scénario Haussier (25 %) : Percées dans l'implantation électrique, approvisionnement HBM plus souple, meilleure performance de la plateforme. Scénario Baissier (20 %) : Retards antitrust/énergétiques > 18 mois, litiges sur la structure du capital d'OpenAI. |

| À Suivre | Accords d'Achat d'Électricité (AAE) signés et détails d'interconnexion ; Capacité et prix HBM ; Termes de l'accord définitif (capital, gouvernance, engagements) ; Preuves de livraison (dates d'expédition Rubin, échelle des clusters) ; Mix cloud d'OpenAI pour la formation. |

| Réflexions sur le Positionnement | Noyau : NVIDIA comme indice du calcul d'IA avec une visibilité de la demande jusqu'en 2028-29. Fournisseurs d'outils (Picks & Shovels) : Surpondérer HBM, l'emballage, l'infrastructure électrique. Couvertures : Surveiller les puces personnalisées et les risques réglementaires. |

Les performances passées ne préjugent pas des résultats futurs. Les investisseurs devraient consulter des conseillers financiers pour des conseils personnalisés basés sur leurs circonstances individuelles et leur tolérance au risque.