Google DeepMind dévoile Gemini Diffusion : Une nouvelle approche dans la génération de texte par IA

Google DeepMind a annoncé hier Gemini Diffusion, un modèle de langage expérimental qui applique pour la première fois à grande échelle l'approche bruit-signal de la génération d'images au texte. Cette percée promet une génération de texte nettement plus rapide avec une meilleure cohérence, bouleversant potentiellement l'approche dominante des grands modèles de langage qui a défini le développement de l'IA pendant des années.

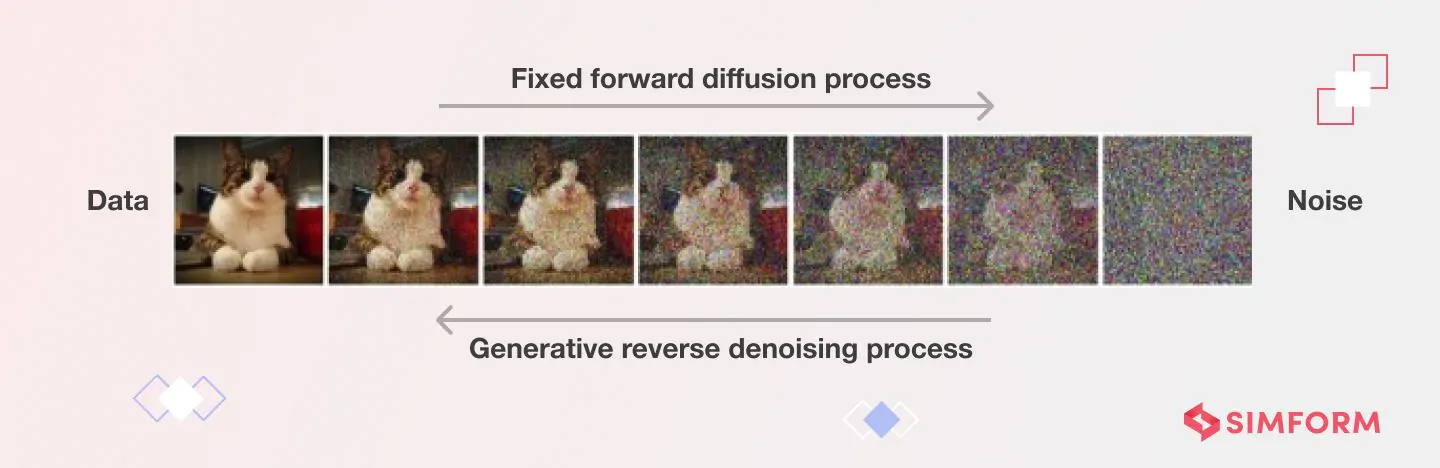

Contrairement aux modèles autorégressifs classiques qui génèrent du texte un token à la fois, Gemini Diffusion fonctionne en affinant le bruit en texte cohérent par étapes itératives. Google affirme que ce processus offre des réponses "nettement plus rapides que même notre modèle le plus rapide à ce jour".

"Cela représente un changement fondamental dans notre façon de penser la génération de langage", a déclaré un chercheur principal en IA familier avec la technologie de diffusion, mais non affilié à Google. "Nous voyons le potentiel d'une amélioration de 4 à 5 fois de la vitesse de sortie de bout en bout par rapport aux modèles autorégressifs de taille comparable. C'est comme sauter plusieurs générations de matériel juste par l'innovation logicielle."

Briser la barrière séquentielle

L'innovation technique derrière Gemini Diffusion s'attaque à une limitation majeure des systèmes d'IA actuels. Les modèles de langage traditionnels comme GPT-4 ou les versions précédentes de Gemini fonctionnent de manière séquentielle, prédisant chaque mot en fonction de ce qui précède. Cette approche, bien qu'efficace, limite intrinsèquement la vitesse et peut entraîner des problèmes de cohérence dans les sorties plus longues.

Les modèles de diffusion adoptent une approche radicalement différente. Au lieu de construire le texte pièce par pièce, ils commencent avec un bruit aléatoire et l'affinent progressivement en contenu significatif par des étapes répétées de suppression du bruit.

"Le processus entier ressemble plus à sculpter qu'à écrire", a expliqué un analyste industriel spécialisé dans les architectures d'IA. "Le modèle considère le contexte complet à chaque étape d'affinage, permettant naturellement la correction d'erreurs et une cohérence globale qui est plus difficile à atteindre avec la génération token par token."

Les résultats de benchmark publiés par Google montrent que Gemini Diffusion atteint une vitesse d'échantillonnage moyenne de 1 479 tokens par seconde, une amélioration substantielle par rapport aux modèles précédents, bien que cela s'accompagne d'environ 0,84 seconde de délai pour chaque génération.

Performances de benchmark mixtes révélant forces et limitations

Les données de benchmark de Google révèlent le profil de performance inégal mais prometteur de Gemini Diffusion. Le modèle montre une force particulière dans les tâches de codage, obtenant 89,6 % sur HumanEval et 76,0 % sur MBPP, pratiquement identiques aux scores de Gemini 2.0 Flash-Lite de 90,2 % et 75,8 % respectivement.

Cependant, le modèle montre des faiblesses notables dans certains domaines. Sur le test de raisonnement difficile BIG-Bench Extra Hard, Gemini Diffusion a obtenu 15,0 % contre 21,0 % pour Flash-Lite. De même, sur le benchmark multilingue Global MMLU, Diffusion a obtenu 69,1 % contre 79,0 % pour Flash-Lite.

"Ce que nous voyons, c'est une technologie qui excelle dans les tâches nécessitant un affinage itératif, comme le codage, où de petits ajustements localisés dans un contexte global sont précieux", a noté un expert en apprentissage automatique dans une grande institution financière. "Les performances plus faibles sur les tâches de raisonnement suggèrent que la diffusion pourrait nécessiter un ajustement architectural pour les applications axées sur la logique."

Malgré ces limitations, Google DeepMind souligne l'efficacité du modèle en termes de paramètres, atteignant des scores de benchmark comparables à des modèles autorégressifs plus grands dans de nombreux domaines.

Défis Techniques dans la Conception et la Mise en Œuvre des Modèles de Diffusion de Texte

| Catégorie de Défi | Défi Spécifique | Description |

|---|---|---|

| Calcul et Efficacité | Exigences de Traitement | Nécessite des centaines à des milliers d'étapes de débruitage, chacune impliquant un passage avant complet à travers un réseau neuronal |

| Problèmes de Latence | L'inférence peut être remarquablement lente, limitant les applications en temps réel | |

| Consommation Mémoire | Exigences mémoire importantes avec de grandes cartes de caractéristiques intermédiaires à chaque étape de diffusion inverse | |

| Mise en œuvre spécifique au texte | Limitations Architecturales | Ne peut pas bénéficier du caching KV en raison du calcul d'attention non causale |

| Limitations de la transition Q_absorb | Débruite les tokens une seule fois, limitant la capacité à modifier les tokens précédemment générés | |

| Inefficacités de Traitement | Les tokens masqués ne fournissent aucune information mais consomment tout de même des ressources de calcul | |

| Longueur de Génération Fixe | Obstacle majeur pour la génération de texte ouverte par rapport aux modèles autorégressifs | |

| Contrôle et Alignement | Problèmes de Précision du Texte | Peinent à adhérer à l'ensemble complet de conditions spécifiées dans le texte d'entrée |

| Problèmes de Fidélité | Génèrent souvent du contenu avec un sens ou des détails erronés malgré une sortie d'apparence naturelle | |

| Sorties Incohérentes | Différents échantillons aléatoires peuvent produire des résultats très différents avec le même prompt | |

| Rendu du Texte | Difficulté à rendre le texte correct et à contrôler le style du texte dans la génération d'images | |

| Théorique et Apprentissage | Défis de la Fonction de Score | Performance liée à l'apprentissage précis de la fonction de score |

| Équilibrage des Compromis | Trouver l'équilibre optimal entre vitesse, coût et qualité reste non résolu | |

| Déploiement | Contraintes de Ressources | Débit de calcul limité, capacité mémoire et budget énergétique sur les appareils périphériques |

| Gestion Thermique | De nombreux appareils dépendent du refroidissement passif, rendant les charges de travail soutenues à haut débit peu pratiques | |

| Intégration en Production | Gérer la latence variable et l'utilisation élevée de la mémoire complique l'intégration système | |

| Problèmes de Sécurité | Prévenir l'utilisation abusive nécessite des garanties robustes qui ajoutent un surcoût | |

| Gestion de Version | Les mises à jour peuvent casser les applications en aval lors du fine-tuning pour des cas d'utilisation spécifiques |

Modification et Affinage : Une nouvelle force de l'IA

L'avantage le plus significatif de l'approche de diffusion est peut-être son aptitude naturelle aux tâches de modification et d'affinage.

"À chaque étape de débruitage, le modèle peut s'auto-corriger les erreurs factuelles ou syntaxiques", a déclaré un professeur d'informatique qui étudie l'IA générative. "Cela rend la diffusion particulièrement puissante pour des tâches comme les dérivations mathématiques ou les corrections de code, où il faut maintenir la cohérence à travers des relations complexes."

Cette capacité d'auto-correction offre une solution potentielle aux défis comme les hallucinations et la dérive qui ont affecté les grands modèles de langage. En considérant l'ensemble de la sortie à chaque étape plutôt que seulement les tokens précédents, Gemini Diffusion peut maintenir une meilleure cohérence sur des passages plus longs.

Accès anticipé et implications futures

Google a ouvert une liste d'attente pour les développeurs intéressés par le test de Gemini Diffusion, le décrivant comme une "démonstration expérimentale pour aider à développer et affiner les futurs modèles".

Pour les utilisateurs professionnels et les investisseurs, les implications vont bien au-delà d'une simple sortie de produit. Les modèles de diffusion pourraient modifier fondamentalement le paysage de l'IA s'ils continuent à démontrer des avantages en termes de vitesse et de qualité.

"Nous voyons potentiellement le début d'une ère hybride", a suggéré un stratège d'investissement en IA dans un grand fonds spéculatif. "Les deux prochaines années pourraient être dominées par des modèles qui combinent la vitesse et la cohérence de la diffusion avec les forces de raisonnement token par token des approches autorégressives."

La technologie semble particulièrement prometteuse pour les outils d'édition interactifs, où les utilisateurs pourraient affiner les sorties de l'IA en cours de génération ou appliquer des contraintes dynamiquement. Cela pourrait permettre un contrôle plus précis que l'ingénierie de prompt actuelle en un seul coup.

Implications sur le marché du changement de diffusion

Pour les traders et investisseurs qui suivent le secteur de l'IA, Gemini Diffusion représente à la fois une opportunité et une perturbation.

"Cette innovation modifie la courbe de coûts pour l'inférence à grande échelle", a déclaré un analyste du secteur technologique. "Les entreprises fortement investies dans une infrastructure optimisée pour les modèles autorégressifs devront peut-être pivoter, tandis que celles travaillant sur les capacités d'édition et les expériences d'IA interactives pourraient voir leur positionnement renforcé."

L'annonce signale une compétition intense dans la course à l'IA, Google tirant parti de la profondeur de sa recherche pour différencier ses offres d'OpenAI, Anthropic et d'autres. Pour les clients d'entreprise, la promesse d'une génération plus rapide avec une qualité comparable pourrait réduire significativement les coûts de calcul.

Cependant, des obstacles importants subsistent avant que les modèles de diffusion ne deviennent grand public. L'écosystème d'outils, les audits de sécurité et les bonnes pratiques de déploiement pour la diffusion de texte sont beaucoup moins matures que pour les modèles autorégressifs. Les premiers utilisateurs pourraient faire face à des défis d'intégration et à une qualité inégale selon les domaines.

"La grande question est de savoir si la diffusion de texte est l'avenir ou juste un composant important de celui-ci", a observé un expert en gouvernance de l'IA. "Le succès appartiendra probablement aux systèmes qui combinent la diffusion avec le raisonnement token par token, la recherche d'information (retrieval) et des couches de sécurité robustes."