Percée de l'IA Open Source : une menace pour les géants de l'animation vidéo

Un nouveau modèle à 14 milliards de paramètres surpasse les systèmes propriétaires, soulevant des questions sur la dynamique du marché et les avantages concurrentiels en intelligence artificielle.

Un changement sismique est en cours dans le secteur de la génération de vidéos par intelligence artificielle, alors que les chercheurs d'Alibaba dévoilent Wan-Animate-14B, un modèle open source qui surpasserait les systèmes propriétaires leaders du secteur en matière de création d'animations de personnages réalistes. Ce développement annonce une perturbation potentielle pour les acteurs établis qui pratiquent des prix élevés pour des capacités similaires.

Lancé via une annonce officielle le 19 septembre 2025, le modèle démontre des performances sans précédent dans deux domaines critiques : l'animation d'images de personnages statiques pour imiter le mouvement humain à partir de vidéos de référence, et le remplacement transparent de personnages au sein de séquences existantes. Des études de préférence humaine indiquent que les utilisateurs préfèrent le résultat de Wan-Animate à ceux de Runway Act-Two et de ByteDance DreamActor-M1, deux systèmes commerciaux qui dominent le marché professionnel.

L'algorithme qui change tout

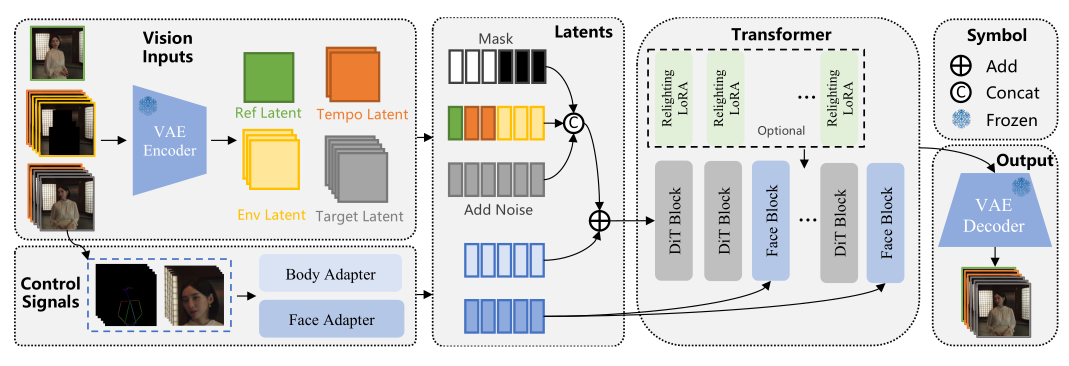

L'architecture de Wan-Animate représente une fusion sophistiquée de technologies existantes, construite sur le modèle de fondation Wan-I2V et utilisant les principes du Diffusion Transformer. L'innovation du système ne réside pas dans de nouveaux algorithmes révolutionnaires, mais dans son approche unifiée pour gérer une double fonctionnalité au sein d'une architecture de modèle unique.

Le modèle fonctionne selon deux modes distincts. En mode animation, il génère des vidéos où un personnage source exécute des expressions et des mouvements à partir d'une vidéo de référence, tout en conservant l'arrière-plan original. Le mode remplacement va plus loin, en substituant le personnage original d'une vidéo de référence par un nouveau personnage, en adaptant l'éclairage et les conditions environnementales grâce à un module LoRA (Low-Rank Adaptation) spécialisé, spécifiquement entraîné pour l'ajustement dynamique de l'éclairage.

Notre analyse interne révèle le mécanisme de contrôle sophistiqué du modèle, qui dissocie le mouvement corporel via des structures squelettiques 2D des expressions faciales en utilisant l'extraction implicite de caractéristiques. Le système injecte directement les informations de squelette spatial dans les latentes de bruit initiales tout en acheminant les données d'expression faciale via des mécanismes d'attention croisée dans les blocs Transformer. Cette séparation architecturale permet ce que les chercheurs appellent une "réplication holistique" des performances de référence avec une fidélité remarquable.

La fondation du modèle sur l'architecture Diffusion Transformer offre des avantages significatifs par rapport aux systèmes traditionnels basés sur UNet, notamment en termes de cohérence temporelle et de qualité vidéo globale. Cependant, les exigences computationnelles sont substantielles, les utilisateurs signalant des erreurs de mémoire insuffisante (out-of-memory) même sur des GPU haut de gamme comme le RTX 5090 lors de tentatives de résolution 1280×720 à 121 images, nécessitant souvent des compromis sur la résolution pour un déploiement pratique.

Validation marché étendue de WAN 2.2

Wan-Animate-14B est issu de la famille de modèles plus large WAN 2.2, qui a obtenu une validation utilisateur significative au sein des communautés créatives. Les retours directs de Reddit, X et YouTube démontrent des améliorations de qualité substantielles en matière de contrôle du mouvement, de mouvements de caméra cinématographiques et de respect des instructions par rapport à la version 2.1 précédente.

Nos tests internes révèlent que WAN 2.2 offre des performances compétitives face aux systèmes commerciaux établis comme Kling et Hailuo, à égalité avec Google Veo 3, en particulier pour le contenu cinématographique de format court. Les capacités de composition du modèle, le contrôle dynamique de la caméra et la performance supérieure de rendu de texte sont tout à fait remarquables. La licence commerciale de style Apache a attiré les créateurs à la recherche d'alternatives aux plateformes commerciales fortement censurées.

Cependant, le déploiement en conditions réelles révèle des contraintes pratiques susceptibles d'affecter une adoption plus large. Les utilisateurs signalent des augmentations exponentielles des temps de rendu avec des nombres d'étapes plus élevés ; des vidéos 720p à 15 étapes produisent d'excellents résultats, mais des séquences plus longues montrent une dégradation de la qualité. La nature « gourmande en VRAM » du système impose des compromis sur la résolution, même sur du matériel haut de gamme, les configurations avec 32 Go de VRAM nécessitant toujours des ajustements pour les clips étendus.

Les retours de la communauté technique identifient des défis persistants, notamment des artefacts de morphing occasionnels, des apparences « plastiques » dans les sorties texte-vers-vidéo, et des caractéristiques tonales sursaturées par rapport aux alternatives commerciales. La calibration de la vitesse de mouvement reste problématique dans les séquences d'action rapide, bien que les flux de travail d'optimisation Lightning et LightX2V offrent des améliorations de vitesse au prix d'une certaine perte de qualité.

Perturbation du marché par l'accès ouvert

Le moment de la publication coïncide avec un examen croissant des investisseurs concernant les valorisations de l'intelligence artificielle et la durabilité concurrentielle. Des entreprises comme Runway, qui ont obtenu un financement à des valorisations de plusieurs milliards de dollars basées en partie sur leurs capacités de génération vidéo, sont désormais confrontées à une concurrence directe de la part d'alternatives disponibles gratuitement.

Notre analyse de marché suggère que ce développement illustre une tendance plus large où les initiatives open source défient les systèmes d'IA propriétaires. Les schémas historiques du développement logiciel indiquent que les alternatives open source de haute qualité compriment souvent les marges et obligent les acteurs établis à innover rapidement ou à risquer l'obsolescence.

La performance du modèle face aux systèmes commerciaux établis soulève des questions fondamentales sur les avantages concurrentiels protégeant les leaders actuels du marché. Les avantages traditionnels comme l'accès aux données, les ressources de calcul et l'acquisition de talents semblent moins décisifs lorsque les modèles fondamentaux deviennent accessibles au public.

Infrastructure de calcul et implications d'investissement

Les exigences en ressources de Wan-Animate présentent à la fois des défis et des opportunités au sein de l'écosystème technologique. Les données de déploiement en conditions réelles révèlent les exigences computationnelles substantielles du modèle, les utilisateurs signalant des limitations de mémoire même sur des configurations matérielles haut de gamme. L'exigence de doubles modèles experts (bruit élevé et bruit faible), d'un encodeur de texte UMT5-XXL et de composants VAE spécialisés crée une architecture de déploiement complexe qui met à rude épreuve les configurations de mémoire GPU traditionnelles.

Les implémentations multi-GPU utilisant les frameworks FSDP (Fully Sharded Data Parallel) et DeepSpeed Ulysses démontrent le potentiel de scalabilité du modèle, mais soulignent également les investissements en infrastructure nécessaires pour un déploiement pratique. Les rapports de la communauté concernant un fonctionnement réussi nécessitant une gestion minutieuse de la mémoire — la résolution 720p devenant la norme pratique même sur les systèmes haut de gamme — soulignent le goulot d'étranglement matériel persistant dans la génération de vidéos par IA.

Cette réalité computationnelle crée des opportunités d'investissement distinctes. Les fabricants de semi-conducteurs spécialisés dans les architectures GPU à haute mémoire pourraient voir une demande soutenue à mesure que les charges de travail de génération vidéo se généralisent. Les fournisseurs d'infrastructure cloud proposant des plateformes d'inférence d'IA optimisées pourraient capter une part de marché significative auprès des organisations cherchant à implémenter des capacités vidéo avancées sans investissements matériels substantiels.

L'émergence de techniques d'optimisation pilotées par la communauté, y compris les flux de travail Lightning et les améliorations des mécanismes d'attention, suggère le développement d'un écosystème parallèle autour de solutions de déploiement efficaces. Les entreprises développant des outils d'optimisation de modèles, des systèmes de gestion de mémoire et du matériel d'inférence spécialisé pourraient trouver des opportunités de marché substantielles à mesure que la technologie dépasse les environnements de recherche.

Transformation de l'économie de la création de contenu

Les industries du divertissement et du marketing sont confrontées à une restructuration potentielle alors que les coûts de production d'animations de personnages de haute qualité diminuent considérablement, bien que l'adoption pratique révèle une transition plus nuancée que prévu initialement. Les créateurs indépendants et les petits studios accèdent à des capacités auparavant réservées aux grandes maisons de production, mais la complexité technique et les exigences computationnelles créent de nouvelles barrières à l'entrée.

Les modèles d'adoption par la communauté indiquent l'émergence d'un marché bifurqué. Les créateurs professionnels développent des flux de travail sophistiqués combinant les capacités cinématographiques de WAN 2.2 avec des pipelines de post-traitement utilisant des outils comme Topaz AI et GIMM-VFI pour l'upscaling et l'interpolation. Ces approches hybrides permettent aux équipes de tirer parti des atouts du modèle pour le contenu de format court tout en palliant ses limites dans les séquences étendues et les contraintes de résolution.

La force du modèle en matière de mouvements de caméra dynamiques et de respect des instructions profite particulièrement aux flux de travail de pré-visualisation dans le cinéma et la publicité. Les studios déclarent utiliser le système pour le développement rapide de concepts et la communication directoriale, bien que la production finale nécessite toujours des techniques traditionnelles pour la qualité et la cohérence. La licence de style Apache supprime les obstacles juridiques qui ont compliqué le déploiement commercial des modèles open source précédents.

Cependant, les limites actuelles de la technologie — notamment l'augmentation exponentielle des temps de rendu, les contraintes de résolution et la gestion des artefacts — suggèrent que l'adoption professionnelle se concentrera probablement sur des cas d'utilisation spécifiques plutôt que sur un remplacement complet des pipelines existants. Les agences de marketing expérimentant le contenu d'influenceurs virtuels et les créateurs de médias sociaux produisant des vidéos de format court représentent les applications commerciales les plus immédiates.

Analyse prospective du marché

La dynamique actuelle du marché suggère plusieurs thèmes d'investissement découlant de ce développement. La convergence des capacités d'IA open source avec les besoins professionnels de création de contenu pourrait favoriser les entreprises capables d'intégrer et de commercialiser efficacement les technologies librement disponibles plutôt que de développer des alternatives propriétaires.

Les fournisseurs d'infrastructure permettant le déploiement et la mise à l'échelle des modèles d'IA pourraient connaître une croissance soutenue de la demande, les organisations cherchant à implémenter des capacités avancées de génération vidéo. Cela inclut les fabricants de matériel spécialisé, les plateformes de cloud computing et les éditeurs de logiciels proposant des outils d'optimisation et de déploiement de modèles.

Les entreprises de médias et de divertissement traditionnelles pourraient avoir besoin d'évaluer leurs stratégies technologiques, potentiellement en déplaçant leurs investissements du développement de capacités d'IA internes vers l'acquisition et l'intégration des meilleures solutions open source. Cette réaffectation pourrait influencer les flux de capital-risque et l'activité de fusion au sein du secteur.

Le paysage concurrentiel semble favoriser les organisations dotées de solides capacités d'exécution, de relations client et d'expertise en intégration par rapport à celles qui reposent principalement sur des avantages algorithmiques. À mesure que la différenciation technique diminue, l'innovation des modèles économiques et l'efficacité opérationnelle deviennent des facteurs de succès plus critiques.

Évaluation des risques et perspectives du marché

Bien que Wan-Animate représente un progrès technique significatif, plusieurs facteurs pourraient affecter son impact sur le marché. Les exigences computationnelles du modèle limitent son accessibilité immédiate, et les défis d'intégration pourraient ralentir son adoption en entreprise. Les réponses réglementaires aux capacités des médias synthétiques restent incertaines, ce qui pourrait affecter les délais de déploiement commercial.

Cependant, la tendance plus large vers le développement de l'IA open source semble durable, suggérant que les entreprises dépendantes d'algorithmes propriétaires de génération vidéo pourraient subir une pression continue. Les investisseurs pourraient bénéficier du suivi des réponses concurrentielles des acteurs établis et de l'évaluation de l'adéquation des valorisations boursières actuelles à ces changements technologiques.

Ce développement souligne le rythme rapide de l'avancement de l'IA et la difficulté à maintenir des avantages concurrentiels basés uniquement sur les capacités algorithmiques. À mesure que le paysage technologique continue d'évoluer, les entreprises qui réussiront seront probablement celles qui sauront s'adapter rapidement pour tirer parti de nouvelles capacités tout en construisant des avantages concurrentiels durables par l'exécution, les relations client et le positionnement stratégique.

Avertissement : Cette analyse est basée sur des informations accessibles au public et ne constitue pas un conseil en investissement. Les performances passées ne préjugent pas des résultats futurs. Les lecteurs sont invités à consulter des conseillers financiers avant de prendre des décisions d'investissement.