Fidelity mène un investissement de 1,1 milliard de dollars dans le fabricant de puces d'IA Cerebras, l'entreprise revendiquant un avantage de vitesse sur les GPU Nvidia

Insurrection du silicium : Le pari à 1,1 milliard de dollars de Cerebras secoue le champ de bataille matériel de l'IA

Fidelity mène un cycle de financement massif qui valorise Cerebras à 8,1 milliards de dollars, signalant que la guerre des puces d'IA est loin d'être terminée.

SUNNYVALE, Californie — Nvidia domine peut-être encore le monde de l'informatique d'IA, mais son emprise commence à se relâcher. Aujourd'hui, Cerebras Systems a levé la somme stupéfiante de 1,1 milliard de dollars lors d'un cycle de financement de série G sursouscrit. L'accord, mené par Fidelity Management & Research aux côtés d'Atreides Management, porte la valorisation de la startup à 8,1 milliards de dollars et la consolide comme l'un des challengers les plus audacieux à l'empire GPU de Nvidia.

Ce financement arrive à un moment charnière. L'attention de l'industrie est passée de l'entraînement de modèles linguistiques gigantesques à leur exécution effective en production. Ce changement expose les faiblesses du matériel existant et ouvre la voie aux entreprises qui construisent des puces avec un seul objectif en tête : une inférence rapide et fiable.

La vitesse est désormais la véritable arme

L'argent afflue car l'inférence — l'acte de mettre les modèles au travail — est devenue le goulot d'étranglement de l'industrie. L'entraînement accaparait autrefois tous les titres, mais aujourd'hui, les entreprises se soucient de gagner des millisecondes sur les temps de réponse. Chaque délai peut frustrer les utilisateurs, ralentir des outils comme les assistants de code, ou même nuire au positionnement concurrentiel.

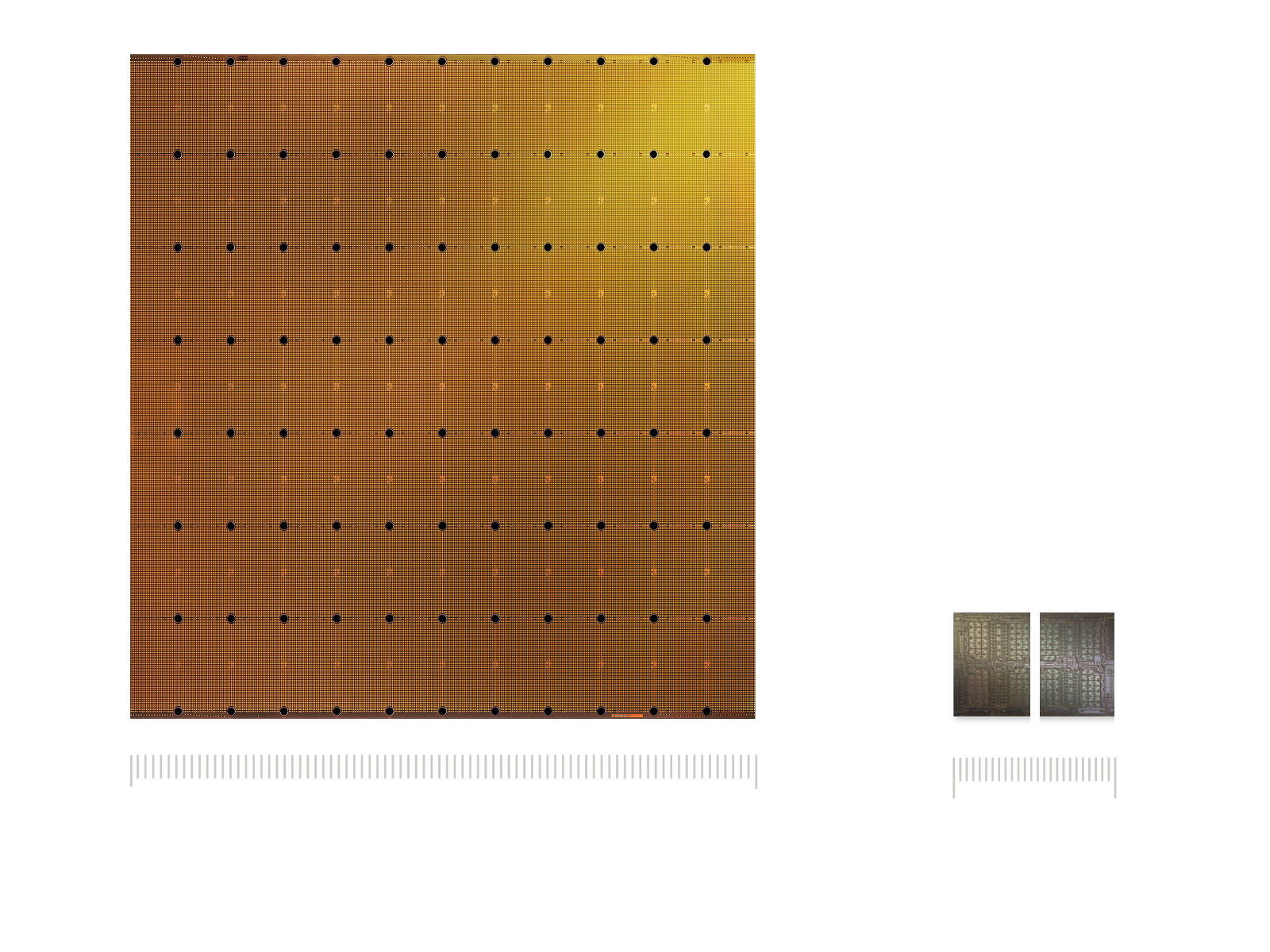

Cerebras affirme que ses systèmes massifs à l'échelle du wafer sont déjà plus de 20 fois plus rapides que les GPU Nvidia sur les principaux modèles open source, selon les benchmarks de la société tierce Artificial Analysis. L'entreprise prétend traiter des billions de jetons (soit des milliers de milliards) chaque mois, non seulement dans les laboratoires, mais aussi dans les centres de données des clients, les infrastructures cloud et les plateformes partenaires.

La liste des clients ressemble à un annuaire des personnalités de la tech. AWS, Meta, IBM et des startups en vogue comme Mistral et Notion sont de la partie, ainsi que les départements américains de l'Énergie et de la Défense. Même les développeurs de Hugging Face semblent préférer Cerebras : l'entreprise est désormais le premier fournisseur d'inférence sur la plateforme, gérant plus de cinq millions de requêtes par mois.

Fabriquer des puces localement

Cerebras prévoit de consacrer une grande partie de ce nouveau capital à la fabrication aux États-Unis et aux centres de données nationaux. Le moment ne pourrait pas être mieux choisi. Washington pousse à l'indépendance en matière de semi-conducteurs via le CHIPS Act, et les agences veulent réduire leur dépendance vis-à-vis d'un seul fournisseur pour des raisons de sécurité nationale.

La stratégie de l'entreprise s'inspire du modèle de Nvidia : contrôler l'ensemble de la pile technologique, de la conception des puces à l'architecture système en passant par la livraison cloud. La différence ? Au lieu de GPU à usage général, Cerebras mise sur des processeurs spécialisés à l'échelle du wafer, conçus exclusivement pour les charges de travail d'inférence. À une époque où la loi de Moore ne garantit plus de gains faciles, la spécialisation pourrait devenir l'atout maître.

Un virage plus large dans l'infrastructure d'IA

Cerebras n'est pas la seule à saisir cette opportunité. Des concurrents et des acteurs adjacents lèvent également d'énormes sommes. Groq a clôturé un financement de 750 millions de dollars en septembre, grâce à des contrats du Moyen-Orient. Des entreprises de photonique comme Celestial AI, Lightmatter et Ayar Labs ont collectivement levé plus de 800 millions de dollars pour résoudre les goulots d'étranglement de la bande passante.

Les géants de la tech construisent également leurs propres puces : MTIA de Meta, Maia de Microsoft, Inferentia d'AWS et les TPU de Google. Chacun représente des milliards de dollars visant à réduire la dépendance à Nvidia. Collectivement, ces initiatives confirment une chose : l'économie de l'inférence justifie des investissements massifs, même si tous les paris ne seront pas gagnants.

Les analystes s'attendent à ce que les dépenses d'infrastructure d'IA atteignent près de 500 milliards de dollars d'ici 2026 et potentiellement 2 800 milliards de dollars d'ici 2029. Mais ces chiffres dépendent de la capacité des entreprises à maintenir des taux d'utilisation suffisamment élevés pour justifier le déploiement de ces infrastructures.

Utilisation et la dure réalité des chiffres

Derrière les gros titres se cache une vérité plus épineuse. Des enquêtes montrent que la plupart des GPU dans les clusters d'entreprise sont inactifs bien plus souvent que ne le supposent les modèles financiers. Même en période de forte demande, de nombreuses installations fonctionnent bien en deçà de leur taux d'utilisation promis de 80 à 90 %. Cet écart est important, surtout lorsque les centres de données sont financés par des milliards de dollars de prêts.

En fait, l'industrie s'appuie déjà sur des structures de financement exotiques. Au cours du seul premier semestre 2025, des entreprises ont émis pour 13,4 milliards de dollars de titres adossés à des actifs de centres de données et contracté plus de 11 milliards de dollars de prêts garantis par des GPU. Certaines transactions ont même frôlé les défauts techniques avant que les prêteurs n'offrent des dérogations.

Ajoutez à cela les contraintes du monde réel — pénuries sur le réseau électrique, lenteur des mises à niveau des services publics et offre limitée de mémoire à large bande passante — et le tableau semble plus fragile que ce que de nombreux investisseurs supposent.

Vraiment, à quel point est-ce plus rapide ?

Les affirmations de Cerebras concernant ses benchmarks soulèvent également des sourcils. Ses chiffres proviennent principalement d'Artificial Analysis, une entreprise à la transparence limitée par rapport aux standards établis comme MLPerf. Pendant ce temps, Nvidia continue d'optimiser au maximum sa pile logicielle. Des optimisations comme TensorRT et la quantification avancée peuvent réduire les écarts de performance sans nouveau matériel, rendant les comparaisons directes délicates.

Les puces spécialisées excellent souvent dans des cas d'utilisation spécifiques, mais peinent lorsque les charges de travail deviennent complexes. Les déploiements réels ne ressemblent pas à des benchmarks soignés — ils impliquent un trafic imprévisible, des longueurs de contexte plus importantes et une demande fluctuante. C'est là que l'économie, et non les présentations marketing, décidera des gagnants.

Ce que les investisseurs devraient vraiment surveiller

Pour les investisseurs, les affirmations tape-à-l'œil sur le débit ne suffisent pas. Les véritables métriques sont simples : coût par millier de jetons à la latence cible, temps d'obtention du premier jeton, énergie consommée par inférence et la constance avec laquelle les systèmes atteignent leurs objectifs de niveau de service. Des audits indépendants sous des charges de travail réalistes ajouteraient bien plus de crédibilité que des démonstrations soigneusement choisies.

Certains analystes soutiennent que les paris plus sûrs se trouvent dans les "fournisseurs d'outils" de l'infrastructure d'IA — fournisseurs de mémoire, systèmes de refroidissement, services publics — car ils en profitent quel que soit le fabricant de puces qui l'emporte. Les startups d'inférence spécialisées comme Cerebras pourraient toujours prospérer, mais elles pourraient mieux s'intégrer comme des paris optionnels dans un portefeuille plutôt que comme des avoirs principaux.

Et n'oublions pas l'ombre menaçante des hyperscalers. Alors qu'AWS, Meta, Google et Microsoft continuent de déployer leurs propres accélérateurs, le marché des puces tierces pourrait se réduire à des niches où le coût, la souveraineté ou la performance brute les rendra indispensables.

Un marché au bord du précipice

La course à la construction d'infrastructures d'IA fait écho au boom des télécommunications des années 1990, lorsque le surinvestissement laissa derrière lui une traînée d'actifs inutilisés. Les projections actuelles exigent une croissance des revenus époustouflante pour suivre le rythme des flux de capitaux. Si cet écart ne se comble pas, la bulle pourrait éclater.

Les résultats possibles sont très variés. Dans le meilleur des cas, Cerebras prouve son avantage, gagne l'adoption des hyperscalers et entre sur les marchés publics comme une véritable alternative à Nvidia. Dans le scénario intermédiaire, elle domine certaines charges de travail tandis que Nvidia conserve la couronne ailleurs. Le pire des cas ? Ses benchmarks s'estompent, l'adoption ralentit, et l'épuisement des liquidités force une vente ou une fusion.

Les investisseurs seraient avisés de demander des preuves concrètes : des métriques auditées issues de déploiements en direct, des contrats d'électricité verrouillés, un approvisionnement confirmé en mémoire critique et des structures de dette claires. C'est ce qui séparera les challengers durables des rêveurs optimistes.

Le cycle de financement de 1,1 milliard de dollars souligne la question centrale de l'infrastructure d'IA aujourd'hui : les puces spécialisées peuvent-elles se tailler une réelle part de marché, ou l'écosystème de Nvidia et ses améliorations logicielles incessantes lui permettront-ils de garder le contrôle ? La réponse ne viendra pas des présentations PowerPoint ni des levées de fonds record. Elle viendra de la performance de ces systèmes en production, à grande échelle, sous pression. Pour l'instant, cependant, les grands investisseurs misent sur le fait que Cerebras a encore toutes ses chances.