L'angle mort conversationnel : le compromis vitesse-intelligence de Claude Haiku 4.5

Anthropic vient de lancer son tout nouveau modèle d'IA "léger", Claude Haiku 4.5, et il s'accompagne d'une promesse audacieuse : une puissance de codage de pointe à une vitesse fulgurante et pour une fraction du prix habituel. Sur le papier, cela ressemble à un rêve : deux fois plus rapide et un tiers du coût des modèles lancés il y a à peine cinq mois. Mais au-delà des gros titres, les premiers utilisateurs en entreprise découvrent une lacune qui pourrait bien remodeler la manière dont les entreprises déploient leurs assistants IA.

Haiku 4.5 écrit du code comme un professionnel. Le problème ? Il ne comprend pas toujours ce que vous voulez qu'il construise.

L'équipe d'ingénierie de CTOL.digital, l'une des premières à utiliser le modèle dans des environnements réels, l'a formulé sans détour : « Le codage est bon, mais il est vraiment difficile de converser et de comprendre les exigences métier ou les conversations quotidiennes normales. » Leur retour, fait écho par de nombreux utilisateurs en entreprise, met en lumière un dilemme croissant dans l'industrie : lorsque l'optimisation de la vitesse et des coûts prime sur la compréhension, l'exécution en pâtit.

L'économie de l'IA « presque de pointe »

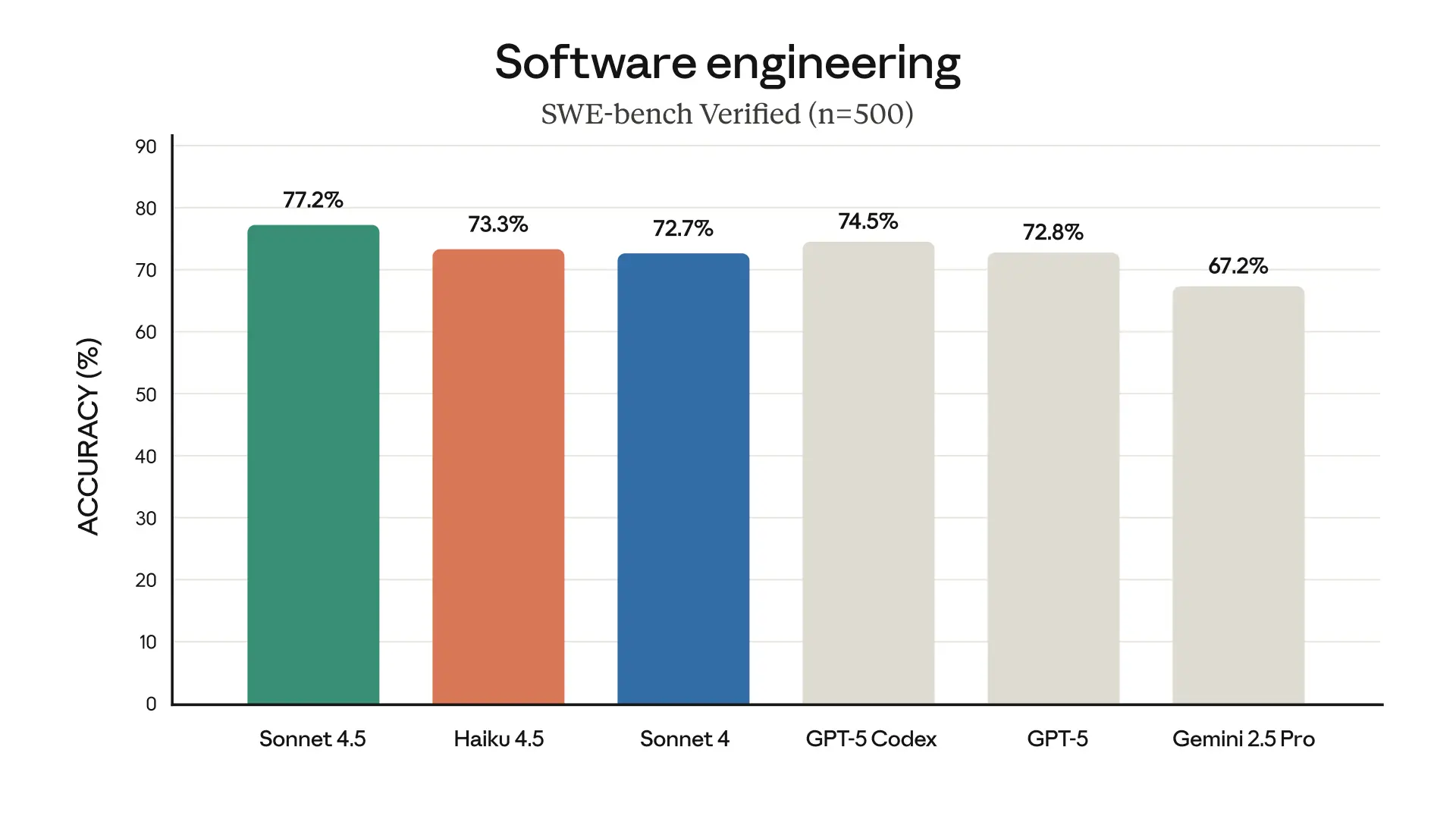

Claude Haiku 4.5 frappe fort en matière de rapport qualité-prix. Il rivalise avec Claude Sonnet 4 – un modèle premium lancé plus tôt cette année – mais pour une fraction de son prix. Sur SWE-bench Verified, l'un des benchmarks de codage les plus exigeants, Haiku atteint une précision de 73,3 % et traite les requêtes plus de deux fois plus rapidement.

La tarification est le véritable choc : 1 $ par million de jetons d'entrée, 5 $ par million de jetons de sortie. C'est le point d'équilibre idéal pour que les entreprises puissent réellement généraliser son utilisation à travers les départements et les systèmes de production.

Anthropic n'a pas seulement lancé un produit, l'entreprise a mené un blitz de distribution. Haiku 4.5 est déjà disponible sur AWS, Google Cloud et même prévisualisé au sein de GitHub Copilot. L'objectif est clair : faire de Haiku 4.5 le moteur par défaut pour le vaste « niveau intermédiaire » des tâches d'IA alimentant les chatbots, les assistants de codage et les automatisations internes.

Un analyste technique a résumé la situation : « Cela redéfinit le prix des modèles "petits mais intelligents" dans l'ensemble du marché. Attendez-vous à une réaction rapide des concurrents. »

Ce que les équipes d'ingénierie disent vraiment

La vitesse et l'accessibilité ne comptent pas si le système interprète mal votre intention. Les tests de CTOL révèlent une constante : Haiku 4.5 excelle dans l'implémentation brute, mais peine avec la conversation humain-IA qui la précède.

Côté technique, c'est impressionnant : « Très rapide et réactif ; qualité de codage proche de celle de Sonnet », selon leurs notes internes. Dans les configurations multi-agents — où un modèle planifie et d'autres exécutent — Haiku 4.5 brille en tant qu'exécuteur.

Mais demandez-lui de collecter des exigences, de discuter d'idées ou de gérer les allers-retours complexes du développement logiciel réel, et des frictions apparaissent. De nombreux testeurs ont décrit un « démarrage difficile » où le modèle est « une véritable plaie » jusqu'à ce qu'ils le forcent en mode codage.

Cela crée un paradoxe étrange : le modèle moins cher finit par exiger plus de compétences de communication de la part de l'utilisateur. Au lieu que l'IA s'adapte aux humains, ce sont les humains qui doivent s'adapter à l'IA.

Le mirage des benchmarks

Anthropic est transparente quant à son processus de test — et cette transparence en révèle beaucoup.

Leurs benchmarks utilisaient :

- Des prompts (invites) très élaborés

- L'utilisation d'outils encouragée « plus de 100 fois »

- Des « budgets de réflexion » massifs allant jusqu'à 128 000 jetons

- Des cadres d'agents (agent frameworks) soigneusement réglés

En d'autres termes, de la grande science, mais les applications du monde réel n'offriront pas toujours ce niveau d'échafaudage. Un analyste a averti : « Attendez-vous à un écart par rapport aux chiffres du blog. »

L'expérience de CTOL le confirme. Avec un prompting parfait, Haiku 4.5 brille. Lors d'une conversation naturelle et désordonnée, il vacille. Et cela compte, car l'objectif même des assistants IA est d'éliminer les frictions, pas d'ajouter des règles sur la manière de parler à une machine.

L'avenir Planificateur-Exécuteur

Anthropic semble le savoir. Au lieu de prétendre que Haiku est une solution universelle, l'entreprise le positionne comme un membre d'une équipe.

Sonnet 4.5 planifie. Haiku 4.5 exécute.

« Sonnet décompose les problèmes complexes en étapes, puis orchestre plusieurs Haiku 4.5 pour accomplir les tâches en parallèle », explique l'entreprise.

CTOL est d'accord. Ils qualifient Haiku d'« idéal comme exécuteur rapide sous un planificateur Sonnet ». Donnez-lui des instructions claires, et il excelle. Demandez-lui de déduire une structure à partir d'une conversation, et il trébuche.

Ce modèle planificateur-exécuteur pourrait devenir la nouvelle architecture d'IA : les modèles coûteux gèrent la compréhension, les modèles bon marché gèrent le travail.

Un compromis judicieux… ou un piège stratégique ?

La faiblesse de Haiku pourrait en fait être intentionnelle. En optimisant pour l'exécution plutôt que pour la compréhension, Anthropic a construit un modèle parfaitement adapté à un rôle spécifique : l'employé fiable qui n'a pas besoin de savoir pourquoi, seulement quoi.

Il y a une logique économique ici. Si 80 % de la charge de travail de l'IA implique l'exécution de sous-tâches bien définies, rendre cela bon marché et rapide permet d'économiser de l'argent. Les 20 % restants — la planification, le raisonnement, la nuance — peuvent être gérés par des modèles premium.

De plus, Haiku 4.5 bénéficie d'une classification de sécurité ASL-2, ce qui signifie moins de restrictions et un déploiement plus large. Les modèles de niveau supérieur restent enfermés derrière des contrôles plus stricts.

Mais cette approche pousse les entreprises vers des configurations multi-modèles. Elles économisent sur les coûts d'exécution, mais doivent payer pour des modèles plus intelligents afin de gérer la partie frontale. C'est un compromis que beaucoup accepteront, mais cela renforce également la dépendance vis-à-vis de fournisseurs spécifiques.

Ce que les entreprises doivent savoir

D'après ce que les premiers utilisateurs ont découvert, voici ce que font les équipes avisées :

N'utilisez pas Haiku 4.5 pour les conversations avec les clients ou la collecte des exigences. Il n'est pas conçu pour cela.

Aiguillez les tâches :

- Codage structuré → Haiku

- Requêtes ambiguës → Sonnet ou autres modèles de haut niveau

Attendez-vous à ce que les performances des benchmarks diminuent en production. Les données du monde réel sont complexes. Prévoyez une marge pour cet écart.

Une agréable surprise : Haiku 4.5 est plus ouvert et coopératif que Haiku 3.5. Les testeurs affirment qu'il s'engage avec des contenus que la version précédente évitait — preuve qu'Anthropic a amélioré son alignement, même si la profondeur conversationnelle est toujours en retrait.

Le tournant de l'industrie

Haiku 4.5 soulève une question plus vaste : allons-nous vers une IA qui collabore véritablement avec les humains, ou vers des outils spécialisés qui nécessitent une manipulation experte ?

L'angle mort conversationnel est important car il représente un recul par rapport à la promesse initiale des grands modèles de langage : que le langage naturel devienne l'interface universelle. Si nous devons « parler IA » pour obtenir de bons résultats, avons-nous vraiment progressé ?

Certaines entreprises ressentent déjà cette tension. Un ingénieur sur Reddit a bien saisi l'ambiance : « Reconnu comme moins cher que Sonnet, mais critiqué comme trop cher par rapport aux modèles économiques d'OpenAI/Gemini et aux modèles ultra-économiques. »

Les prochains mois décideront de la direction. Le modèle planificateur-exécuteur deviendra-t-il la norme, ou quelqu'un trouvera-t-il la combinaison gagnante : rapide, bon marché et profondément conversationnel ?

D'ici là, Haiku 4.5 offre une exécution brillante — ne vous attendez simplement pas à ce qu'il comprenne pleinement ce que vous voulez dire sans être guidé. Comme l'équipe de CTOL l'a appris à ses dépens : la vitesse est puissante, mais la compréhension est essentielle.

Anthropic a refusé de commenter les retours spécifiques, mais a renvoyé à la documentation technique et à la fiche système du modèle pour les détails sur ses capacités et ses limitations.

Cet article s'appuie sur des notes de tests internes, de la documentation technique et des entretiens avec des utilisateurs professionnels de Claude Haiku 4.5. Certaines sources ont demandé l'anonymat afin de s'exprimer librement sur les systèmes d'IA en phase de développement précoce.